2023-07-13 06:00:30 发布

发布

作者 | 周愚

编辑 | 邓咏仪

36氪获悉,7月11日,百川智能公司正式发布通用大语言模型Baichuan-13B-Base、对话模型Baichuan-13B-Chat及其INT4/INT8两个量化版本,参数量达130亿。

这是自今年4月成立以来,百川智能发布的第二款通用大语言模型。6月15日,百川智能推出首款70亿参数量中英文语言模型——Baichuan-7B,36氪此前也做过报道。

预训练模型“底座”因其灵活的可定制性,适合具有一定开发能力的开发者和企业,而普通用户则更关注具有对话功能的对齐模型。本次发布13B-Base的同时,百川智能也发布了其对话模型Baichuan-13B-Chat,对开发者而言部署简单、开箱即用。

而百川智能还同时开源了Baichuan-13B-Chat的INT8和INT4两个量化版本,可以被近乎无损地部署在如3090等的消费级显卡上。

相比此前发布的Baichuan-7B,这次发布的Baichuan-13B是参数量更大的版本。Baichuan-13B在1.4万亿token数据集上训练,参数量超过LLaMA-13B 40%。

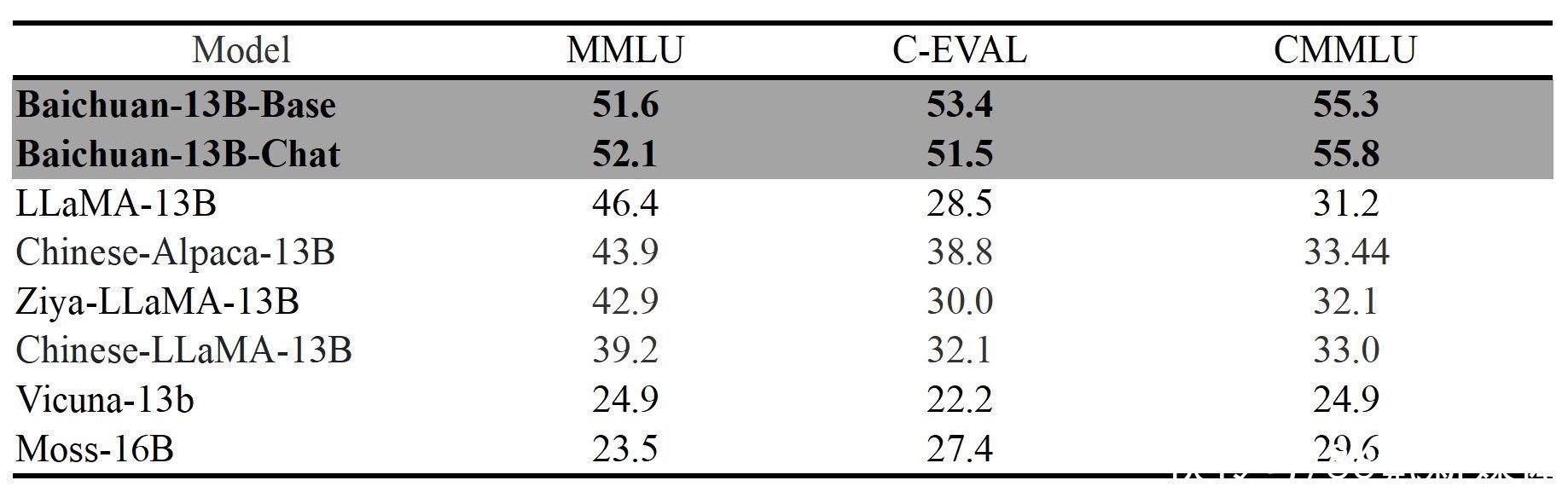

据百川智能,Baichuan-13B在C-EVAL、MMLU等中、英文领域权威评测榜单上均进行了能力测试,测试结果位于国内外大模型的前列。

在中文C-EVAL评测中,Baichuan-13B-Base、Baichuan-13B-Chat分别取得53.4分、51.5分。来源:百川智能

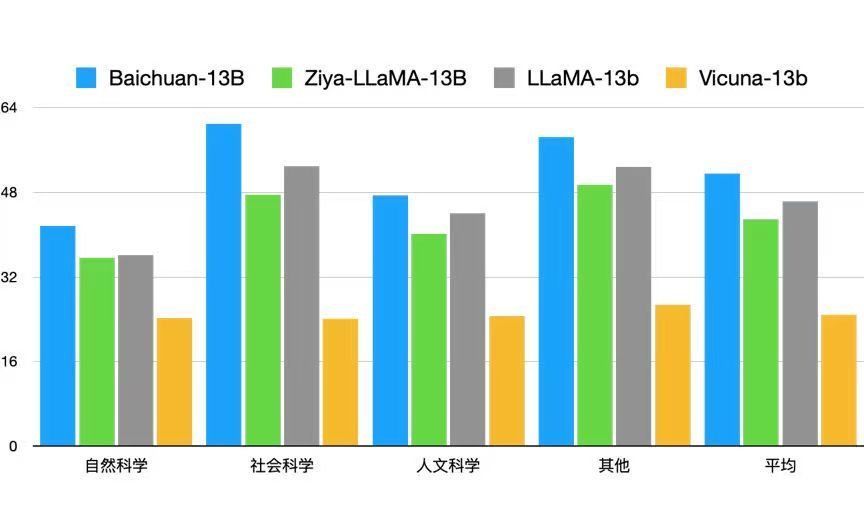

比如,在中文领域权威评测C-EVAL中,Baichuan-13B得分在自然科学、医学、艺术、数学等领域,超过了Meta旗下的LLaMA-13B等同尺寸的大语言模型;而在社会科学、人文科学等领域,超过了ChatGPT。

而在英文权威评测榜单MMLU上,Baichuan-13B得分则在所有领域内,超过了包括LLaMA-13B在内的所有同尺寸开源模型。Baichuan-13B-Base和ChatGPT的得分,分别达51.6分和52.1分。

Baichuan-13B在中文评测C-EVAL上的表现。来源:百川智能

Baichuan-13B在英文评测MMLU上的表现。来源:百川智能

面向中文语言模型的C-Eval评测基准,是由上海交通大学、清华大学以及爱丁堡大学联合创建,覆盖了52个来自不同行业领域的学科。 MMLU则主要是对模型的英文跨学科专业能力进行深入测试,由加州大学伯克利分校等知名高校共同打造,集合了不同领域的57个学科。

在语言模型中,上下文窗口长度对于理解和生成与特定上下文相关的文本至关重要。Baichuan-13B上下文窗口长度为4096,不同于Baichuan-7B的RoPE编码方式,Baichuan-13B使用了ALiBi位置编码技术。

该技术能够处理长上下文窗口,甚至推断超出训练期间读取数据的上下文长度,从而更好捕捉文本中上下文的相关性,做出更准确的预测或生成。

此外,为了取得在中、英两种语言中的均衡表现,Baichuan-13B采用了相对平衡的中英文语料配比和多语言对齐语料。

本次发布依然延续开源、可商用的原则。目前,Baichuan-13B-Base和Chat均已发布在Hugging Face、Github以及Model Scope平台上。该模型对学术研究完全开放,其他开发者在获得官方商用许可后,即可免费试用。

附项目开源地址:

Hugging Face:

预训练模型:https://huggingface.co/baichuan-inc/Baichuan-13B-Base

对话模型:https://huggingface.co/baichuan-inc/Baichuan-13B-Chat

Github:https://github.com/baichuan-inc/Baichuan-13B

Model Scope:

预训练模型:https://modelscope.cn/models/baichuan-inc/Baichuan-13B-Base/

对话模型:https://modelscope.cn/models/baichuan-inc/Baichuan-13B-Chat/